¿Google disavow link o herramienta para despenalización?

Publicado el 21 de octubre del 2012

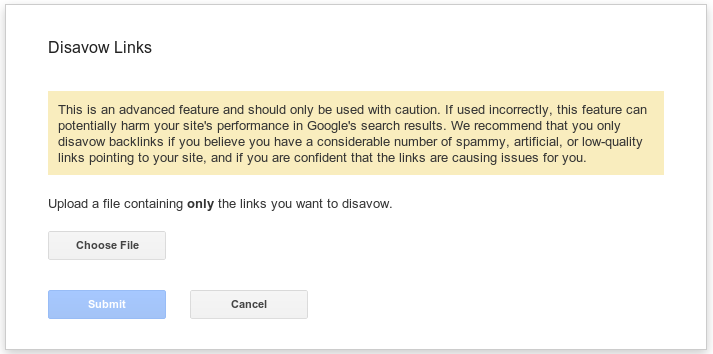

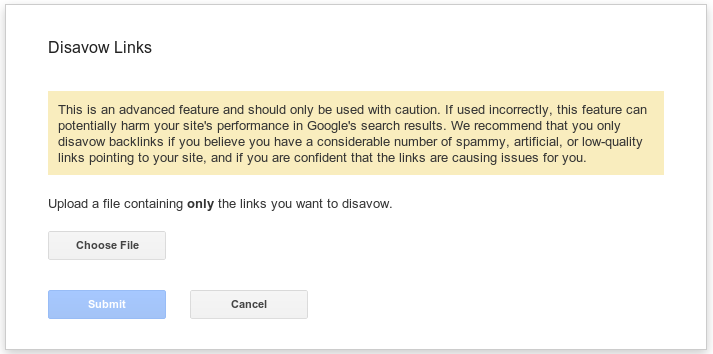

Esta semana Google ha lanzado una nueva funcionalidad dentro de Webmaster Tools, se trata de una opción para indicar a Google que enlaces hacia tu site debe ignorar porque creas que son de dudosa calidad. Para ello se debe subir un fichero de texto con las urls donde están los enlaces que quieres desautorizar, puedes hacerlo a nivel de domino (todos los enlaces de ese dominio) o a nivel de URL (puedes enviar URLs concretas).

Según comentan desde Google si no has recibido un mensaje de de Webmaster Tools donde te indique que tienes enlaces sospechosos hacia tu site no deberías usar este método, es la última alternativa, primero recomienda pedir al otro webmaster que te quite el link, y en el caso de que no responda o no sea posible, usar esta herramienta.. Supuestamente Google omitirá esos enlaces a la hora de calcular la posición de tu web para cada búsqueda.

¿Tendrá en cuenta Google si una web recibe muchas peticiones de desautorización de enlzces desde muchos sites?

¿Servirá para levantar penalizaciónes?

¿Servirá para algo?

Como siempre vamos a aprovechar el post para intentar averiguar algo, de momento vamos a linkar con esta palabra inventada, kartyhnioas, a una url nueva que no está indexada en Google, dentro de un mes o así desautorizaré ese enlace y veremos si Google lo omite o no lo omite.

ACTUALIZACIÓN:

Este experimento ha sido un total fracaso por mi parte ya que tengo un puñetero canonical en la landing page... así que no vale para nada. Volveré a repetirlo en cuanto vuelva de VACACIONES!!!!

Esta semana Google ha lanzado una nueva funcionalidad dentro de Webmaster Tools, se trata de una opción para indicar a Google que enlaces hacia tu site debe ignorar porque creas que son de dudosa calidad. Para ello se debe subir un fichero de texto con las urls donde están los enlaces que quieres desautorizar, puedes hacerlo a nivel de domino (todos los enlaces de ese dominio) o a nivel de URL (puedes enviar URLs concretas).

¿Tendrá en cuenta Google si una web recibe muchas peticiones de desautorización de enlzces desde muchos sites?

Se podría pensar que si un dominio es desautorizado por mcuhos webmasters de otros dominios es que ese dominio es de dudosa confianza. Creo que es una opción que tiene todo el sentido. Pero estas declaraciones por parte de Google me hacen pensar que no lo usan para detectar esas posibles webs que venden / intercambian o donde es fácil crearse enlaces

"Si has hecho todo lo que está en tus manos para eliminar los enlaces problemáticos pero sigues viendo enlaces que no puedes retirar, es hora de visitar nuestra nueva página de desautorización de enlaces. "

Si su función fuese identificar posibles focos de link building esta no sería una recomendación adecuada, les resultaría mucho más eficaz una así "si detectas cualquier enlace sospechoso a tu web usa nuestra herramienta, es la mejor manera para comunicar a Google la desautorización de ese enlace" para incitar a la gente a "denunciar" esas webs, pero no es el caso, pide lo contrario, que sea la última opción.

¿Servirá para levantar penalizaciónes?

Yo creo que si Google está diciendo que tomemos esta opción sólo si recibimos un mensaje de enlaces sospechosos por parte de WMT y que con esto podemos decirle que los ignore y no los tenga en cuenta en su algoritmo está dando a entender que una web podría salir de una penalización por compra de links simplemente desautorizando esos enlaces que compró. Esto me parece que no sería una decisión acertada por parte de Google, daría pie a que muchos arriesgaran más en su estrategia de compra de links, pensarán, total... si me pillan, los desautorizo y comienzo otra vez.

¿Servirá para algo?

No sé... a veces pienso que Google ha sacado esta herramienta porque Bing tenía ya una igual, y no les cuesta nada crear ese formulario para subir un fichero de texto, vete tú a saber!! Pero me resulta un poco extraño que Google posibilite una herramienta para salir de penalizaciones. La razón "oficial" es para combatir al Negative SEO, pero yo lo veo como una herramienta de despenalización si es tal como dicen, cosa que también dudo...

Como siempre vamos a aprovechar el post para intentar averiguar algo, de momento vamos a linkar con esta palabra inventada, kartyhnioas, a una url nueva que no está indexada en Google, dentro de un mes o así desautorizaré ese enlace y veremos si Google lo omite o no lo omite.

DUQUE (@)hace Hace más de 12 años y 162 días

Para mi la utilización de la herramienta solo se justifica si Google te ha dado una buena hostia a causa de alguna actualización de su algoritmo relacionado con la relevancia de los links que te enlazan y realmente es por algún problema del tipo:

Han sindicado mi contenido y esto ha producido una gran cantidad de enlaces hacia mi sitio desde páginas de baja calidad.

Vamos que si te han cazado por spammer y le metes una disavow links, pasas entonces por las manos de un quality y realmente ve que estas dentro de una link wheel o algún tipo de esquema de enlaces te van a follar y sobretodo si lo haces después de una actualización del algoritmo.

Muy complicado utilizar esta herramienta si realmente no eres un buen chico.

Errioxa (@)hace Hace más de 12 años y 162 días

@Duque lo que comentas de "pasas entonces por las manos de un quality" ¿es seguro? ¿han dicho que lo revisarán humanamente? Porque no estoy tan seguro de ello...

Yo estoy haciendo la prueba con este blog, a ver si posiciona la web a la que linko y luego pruebo la opción de invalidar el link a ver que pasa. Pero eso, lo hago con este blog que me da totalmente igual su posicionamiento, está para lo que está, compartir... pero NO LO HARÍA de momento en ninguna web que me importara hasta que se sepa más, por lo que comentas, quizás nos ponga una banderita.

Jordi (@)hace Hace más de 12 años y 161 días

Indepedientemete del uso que pueda tener la herramienta, tal y como apunte en un post, seguro que G aprovecha para construir "entre todos" una maxi-lista negra de webs con enlaces de "dudosa reputacion"... ¿Qué ara con la lista?

Errioxa (@)hace Hace más de 12 años y 161 días

@Jordi pero si fuese así no aconsejaría que esto fuese el último recurso, sino que diría que es el mejor recurso, para así captar cuántos más mejor, ¿no??

@jordisancho (@)hace Hace más de 12 años y 161 días

@errioxa Tiempo al tiempo! Que siga enviando mensajes a los webmasters avisando de enlaces "malos" y seguro que no le cuesta mucho! EL tiempo dirá

@DelgadoCrist (@)hace Hace más de 12 años y 161 días

La verdad a mi esta herramienta me trae mala espina, pero solo el tiempo dira si realmente funciona, pero....

"No es más limpio el que más limpia sino el que menos ensucia" kokebcn dixit.

Rodrigo (@)hace Hace más de 12 años y 160 días

El que use esta herramienta ayudará a la creación de listas negras:

Lista negra de sites spammers

Lista negra de webmasters que hacen marranadas con los links

Estoy con Duque en que debería ser un ultimísimo recurso, la última bala...

Errioxa (@)hace Hace más de 12 años y 158 días

Ojo, la página a donde apuntaba el enlace tenía un meta noindex, el día 27 de octubre se la he quitado.

A parte de retrasar el test, no debería influir en el resultado. Esperemos que Google posicione esa landing los próximos días, y luego, usaremos la herramienta con este link, a ver si vemos algo.